История развивается по спирали и одной из важных ее «завитушек» в области IT-индустрии является компания NVIDIA. Это один из пионеров рынка графических ускорителей, наравне с компанией 3Dfx, которую она впоследствии купила, и ATI, которая сейчас принадлежит AMD. То, что мы на данный момент видим на рынке мобильных SoC (System-on-Chip, система-на-чипе) сильно напоминает компьютерную «гонку вооружений», особенно активно длившуюся с конца 90-х прошлого века. Если обрисовать ее упрощенно, то одни разработчики выпускали игры с непомерными требованиями к графической подсистеме, а другие предлагали те самые ускорители, смачно приправляя их рекламной шелухой о новых спецэффектах, невиданной доселе фотореалистичной графике и т. д.

По факту же оказывалось, что эти невероятные спецэффекты можно увидеть в паре модных игрушек, через полгодика после релиза ускорителя и то, на максимальном качестве графики они работали на текущем поколении видеокарт не очень шустро. Пишу об этом, основываясь на личном очень богатом опыте компьютерного «железячника» и игромана, через чьи руки прошли практически все поколения видеокарт, включая решения от упомянутой выше 3Dfx, до нее — слабые потуги S3 (может, кто помнит такой ускоритель как Virge и компанию Diamond Multimedia, славившуюся своими видеокартами Stealth и Monster), NVIDIA с ее Riva TNT, выросшей впоследствии в GeForce и прочие. Так вот, очень похожая «гонка вооружений» сейчас наблюдается и на мобильном рынке, где NVIDIA пытается применять однажды испытанные методы, но сработают ли они? Ведь были уже промашки. Что ж, теперь история повторяется вместе с SoC Tegra 3, которую разработчик сочно описал и прорекламировал, а также местами сравнил с конкурентами.

Diamond Stealth 3D 3000 — очень дорогая и очень крутая для своего времени (1995-96 годы) видеокарта с дополнительным модулем видеопамяти

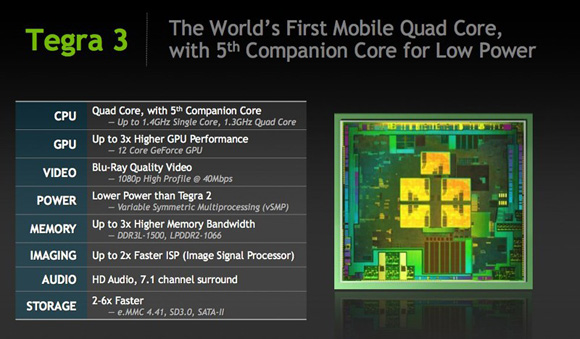

Итак, что же предлагает NVIDIA в своей новой SoC? В первую очередь — много ядер, если точнее, то пять. Вообще, принято упоминать лишь о четырех основных вычислительных ядрах, но есть еще и пятое, так называемое ядро-компаньон, которое призвано снизить общее энергопотребление системы на чипе. Оно используется в большинстве задач, включая воспроизведение видео, и по своей энергоэффективности практически вдвое превосходит современные одноядерные процессоры с аналогичной частотой. Например, может воспроизводить видео в разрешении 1080p в течение 12 часов от стандартного для современных портативных устройств аккумулятора. Максимальная частота SoC, когда работают четыре основных ядра (они автоматически включаются в работу при повышении нагрузки на устройство) составляет 1,3 ГГц, для одного ядра этот показатель — 1,4 ГГц.

Модная SoC Tegra 3 и ее характеристики

Прежде чем перейти к рассмотрению графических возможностей новинки, которые оказались в сравнении с конкурентами не столь впечатляющими, как их пытается показать NVIDIA, упомяну о других менее заметных простому пользователю особенностях. Так, Tegra 3 способна качественно воспроизводить видео уровня Blu-ray, а это разрешение 1080p при потоке в 40 Мбит/с. В SoC почти втрое увеличена пропускная способность шины памяти, а скорость дисковой подсистемы в зависимости от используемого интерфейса и типа флэш-памяти возросла от 2 до 6 раз. Еще есть поддержка HD-аудио и 7.1-канального звука. Для смартфона это, конечно, не нужно, но неким будущим аналогам нетбуков на базе Tegra 3 не помешает. Не стоит забывать и о 3D. Трансляция стереоскопического изображения на внешний экран легко дается новой системе на чипе. Хотя, это набившее оскомину 3D, по сути, особо потребителям и не нужно. Красивая реклама, интересный для кинотеатра эффект, но в бытовых условиях он может превратиться в самый настоящий «вырвиглаз» (головная боль, головокружение, тошнота — говорят, что таким симптомам при просмотре 3D подвержено лишь 10% населения, но жалоб, на самом деле, больше).

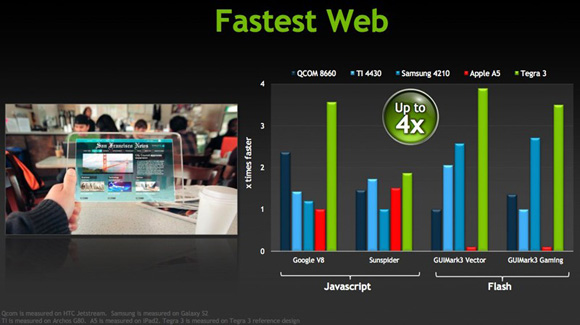

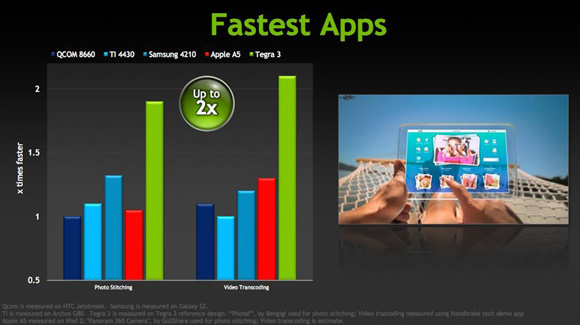

Не забыла NVIDIA сравнить производительность Tegra 3 в некоторых задачах с конкурентами. В данном случае ключевое выражение «в некоторых задачах». В частности, речь идет о веб-серфинге и работе приложений. Apple A5 в первом случае опущен ниже плинтуса, особенно это касается технологии Flash, поддержки которой, как мы знаем, в iOS официально нет (и не будет). Что касается «числодробильной» мощи для приложений, то, естественно, у новой SoC она выше в сравнении с конкурентами, принимавшими участие в тестировании NVIDIA. Ведь в Tegra 3 четыре основных ядра Cortex-A9, а у конкурентов их по два. Вот и получается примерно двукратное их отставание от новичка-красавца.

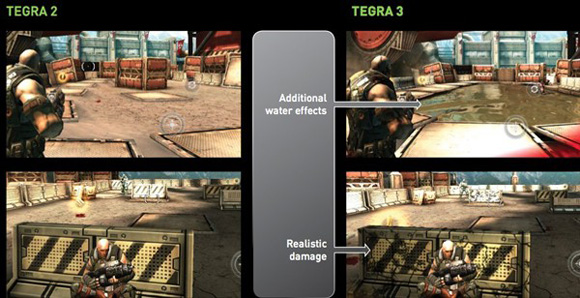

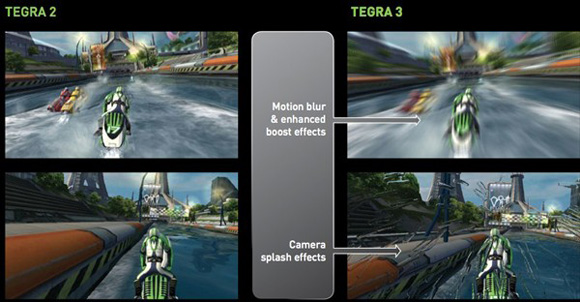

А теперь самое интересное — что же такого компания накрутила в графической подсистеме новой SoC? На одном из презентационных слайдов выше есть такая скромная надпись: «До трех раз выше производительность GPU, 12-ядерный видеочип GeForce». Звучит внушительно. Более того, NVIDIA сварганила шикарную демонстрацию возможностей Tegra 3 в играх, которую можно оценить ниже:

Вот он, тот самый метод запудривания мозгов потребителей, не раз испытанный в области PC. Красивые эффекты, модные игры, вот только в данном случае он может и не сработать. Уж слишком велика конкуренция на рынке. Давайте разберем все по порядку. Компания заявляет о трехкратном увеличении производительности в сравнении с Tegra 2, но этот чип, как показывают тесты, далеко не самый мощный. Вспоминаем тестирование Galaxy SII кудесниками из AnandTech и видим, что SoC Apple A5 вчетверо превосходит Tegra 2 по скорости рендеринга, Samsung Exynos 4210 — вдвое. То есть графическая подсистема в iPad 2 и в iPhone 4S заведомо мощнее, чем в будущих продуктах на базе Tegra 3. А значит все эти вкусные «плюшки», что показали разработчики выше, должны быть доступны и для iГаджетов. Решение от Samsung тоже далеко не самое новое, но и оно не особо сильно уступает в производительности новичку. Не забываем, что в работе находятся и Apple A6, и новые корейские SoC Exynos, которые выйдут на рынок в реальных продуктах весной-летом следующего года. Как раз к тому времени, как Tegra 3 начнет становиться более-менее массовым решением.

Shadowgun и Sprinkle есть для iOS, ждем модных эффектов с их очередным обновлением

В итоге выходит, что NVIDIA яростно выпячивает игровые возможности своей платформы, скромно умалчивая, что и у конкурентов они неслабые. А у некоторых, например у Apple, «железо» и того мощнее. Графические библиотеки тоже используются единые, и все эти эффекты легко реализуются на любом современном мобильном ускорителе. На этом фоне от производителей особенно забавно слышать в видеоролике что-то вроде: «Повышенная производительность Tegra 3 позволила нам реализовать суперэффекты, увеличить скорость рендеринга до 60 кадров в секунду, в то время как на других платформах она ограничена 30 кадрами». Ребята, а как же Apple A5, ведь эта SoC еще мощнее, как же Samsung Exynos?

Все это очень похоже на «троллинг» простых потребителей со стороны NVIDIA. Компания активно пускает пыль в глаза, а лучше бы акцентировала внимание на более важных вещах, на тех же драйверах для Android. Ведь это позорище, что нормального ускорения видео до сих пор в ПО Tegra 2 не реализовано. Можно сослаться на Google и недоделанность Android, но ведь Samsung без проблем реализовала эту функцию для своих SoC. А вспомнить историю с «HD-играми» для Android, которые якобы были заточены только под Tegra 2, но тут, вот незадача, какие-то энтузиасты выпускают маленький патчик, и волшебным образом такие игры запускаются на любых Android-устройствах с более-менее мощным железом. Кроме того, все эти HD-игры прекрасно себя чувствуют и на iOS.

SoC Tegra 3 бесспорно хороша, но, все-таки, может стоит акцентировать внимание на других вещах? Однобокая реклама технологий — это путь в никуда, рано или поздно пользователи просто перестанут обращать внимание на потуги компании, а вместе с тем и производители тоже. Пусть это будет стабильно работающий сплав «железа и софта», чем однобокий набор технологий, которые и применить-то реально негде из-за кривизны программного обеспечения. То, что было применимо на PC-рынке, может и не сработать на мобильном, но ведь в ходе этого «троллинга» потребителей страдают их кошельки, что плохо. Очень малый процент людей досконально знает характеристики имеющихся в наличии устройств, зато подавляющее большинство активно смотрит рекламу и ведется на нее, а потом, после покупки «волшебного» устройства, наступает разочарование им. Потому что по факту вся эта красота оказывается лишь яркой цветной пылью, запущенной в глаза умелыми руками маркетологов.

Может в этом и есть один из секретов успеха iГаджетов? Они просто работают и делают это хорошо, именно так, как и обещает в презентациях и рекламе Apple.

44 комментариев

Форум →